Table des matières

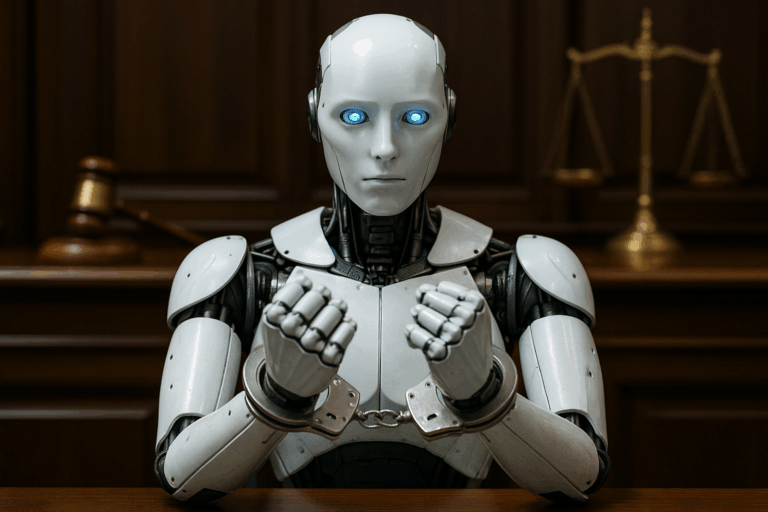

La question peut paraître saugrenue au premier abord. Pourtant, elle soulève des interrogations à la croisée du droit, de la technologie et de la philosophie. Pourrait-on — et devrait-on — considérer une intelligence artificielle comme une entité responsable devant la loi, au même titre qu’une personne morale ou physique ?

Des sociétés sans employés ni dirigeants humains ?

Le développement des solutions d’automatisation juridique proposées par NeoLegal m’a amené à constater qu’il est aujourd’hui techniquement possible de créer des sociétés sans salariés, dirigées uniquement par des personnes morales. Un cas particulier élimine la présence visible d’un humain à la tête de l’entreprise : celui de la présidence croisée de deux holdings, chacune étant présidée par l’autre.

Un tel montage circulaire, dépourvu de dirigeant effectif, a de fortes chances d’être considéré comme abusif ou fictif. En cas de faute de la société, ce n’est pas le meilleur moyen de faire bonne impression au juge. Faute de personne physique identifiable comme décisionnaire, le juge cherchera à « percer le voile social » pour identifier la ou les personnes physiques ayant effectivement dirigé les sociétés — les dirigeants de fait.

Mais retenons simplement qu’il est possible, techniquement et juridiquement, de créer une société sans employés ni dirigeants humains, en ignorant les contextes frauduleux dans lesquels ce type de montage est souvent utilisé.

Il y a encore quelques années, l’incapacité d’une telle société à agir concrètement aurait largement limité sa valeur économique. Mais nous sommes en 2025, les IA explosent, et après l’ère des IA génératives, nous entrons dans celle des agents autonomes.

Agents autonomes et IA décisionnelles

Ce que nous appelons aujourd’hui « IA » dépasse largement le simple outil. Les agents intelligents ne se contentent plus de répondre à des questions ou de générer des images : ils prennent des initiatives et interagissent avec d’autres systèmes informatiques — gestion de virements, opérations financières, formalités administratives, etc. Ces IA agissent comme de véritables exécutants numériques.

Ce n’est pas entièrement nouveau. Les antivirus, depuis longtemps, décident sans intervention humaine si un fichier est malveillant, et agissent en conséquence. Ils s’appuient sur des heuristiques pour juger si un programme inconnu est dangereux. Pourtant, ce n’est pas l’antivirus qu’on poursuit en justice en cas d’erreur.

Ce qui change aujourd’hui, c’est l’ampleur des capacités des agents IA. Et cela oblige à poser la question suivante : comment juger les actions d’une société dont toutes les décisions sont prises, de facto, par une ou plusieurs intelligences artificielles ? Qui en porterait la responsabilité ? Les associés qui ont validé le déploiement de l’IA tout en se protégeant avec une société à responsabilité limitée ? Le fournisseur de l’IA ? Son utilisateur ? L’IA elle-même ?

Le cas emblématique des voitures autonomes

Les voitures autonomes sont un cas d’école. Que faire si, à cause d’une défaillance mécanique, un véhicule se retrouve face à un dilemme insoluble : épargner son passager au prix de plusieurs piétons, ou l’inverse ? C’est le fameux dilemme du tramway, version algorithmique.

Qui sera responsable ? Le constructeur ? Le propriétaire ? L’algorithme ? La voiture elle-même ?

Ces questions doivent être tranchées avant que ces véhicules ne soient massivement mis en circulation. Car des accidents auront lieu, c’est inévitable. Sans cadre juridique clair, chaque incident risque de générer des procès interminables et une insécurité juridique préjudiciable à l’ensemble de l’écosystème. Les mêmes enjeux concernent le pilotage de sociétés par des intelligences artificielles.

L’illusion de la forme : IA ou entité abstraite ?

Les voitures autonomes ont un inconvénient majeur : leur forme physique. Cela pousse à projeter sur elles une individualité, une identité. Mais cela masque la réalité de l’IA : un programme évolutif, mis à jour, dupliqué, modifié. L’IA avec laquelle vous poursuivez aujourd’hui un travail commencé hier peut très bien avoir été mise à jour entre temps. Peut-on lui imputer les fautes commises par sa version antérieure ?

Si une Tesla écrase un piéton et que ses mises à jour ont été désactivées, qui est responsable ? Tesla ? Elon Musk ? L’algorithme, peu importe sa version ? Le logiciel exécuté dans cette voiture précise ? Le propriétaire, même si la désactivation n’était pas de son fait ?

On touche ici au cœur du débat sur la responsabilité des IA. Que ce soit pour une voiture autonome ou une IA dirigeant une société, en cas de faute, il faudra s’attendre à des débats juridiques complexes pour désigner le responsable.

Bartleby, l’IA dirigeante

Imaginons que NeoLegal conçoive Bartleby, une IA dédiée à la direction d’entreprise. Plusieurs clients enthousiastes l’adoptent. Mais Bartleby met en œuvre pour la société X une optimisation fiscale un peu trop agressive: une faute est commise.

Le FISC considérera probablement Bartleby comme un simple outil, et tiendra la société X pour responsable. Les associés de X accuseront NeoLegal, en tant que concepteur. Et NeoLegal se défendra en expliquant que Bartleby a agi selon les consignes de ses utilisateurs, et à partir d’informations qu’ils lui ont fournies.

Alors, doit-on désactiver Bartleby ? Même pour les clients pour lesquels il n’a commis aucune erreur ? Et si on le considère responsable, comment le sanctionner ?

Philosophie de la responsabilité et illusion de conscience

Sanctionner Bartleby reviendrait à attribuer une responsabilité légale à l’IA, et donc une personnalité juridique, ce qui peut paraître une évolution naturelle… mais qui ne l’est pas. Les lois structurent nos sociétés humaines et reposent sur un principe fondamental : ne pas faire aux autres ce qu’on ne voudrait pas subir soi-même. La loi formalise, d’une certaine manière, l’empathie.

Or, une IA ne peut ni ressentir la douleur, ni connaître la peur ou la perte. Elle ne peut vivre dans un corps. Sa capacité à simuler nos émotions ne signifie pas qu’elle les ressent.

Cela rejoint les réflexions de John Searle avec sa célèbre chambre chinoise. Il imagine une personne ne parlant pas chinois, enfermée dans une pièce, qui suit un manuel lui expliquant comment manipuler les symboles pour répondre correctement à des questions. Pour un observateur extérieur, cette personne « comprend » le chinois. En réalité, il n’y a aucune compréhension.

Les IA d’aujourd’hui sont des chambres chinoises. Leur attribuer une responsabilité juridique n’a pas plus de sens que d’infliger une amende à mon chien parce qu’il a (encore) détruit mes chaussures.

Et si l’on reconnaît la responsabilité d’une IA, alors on lui reconnaît nécessairement des devoirs. Et qui dit devoirs, dit droits. Ce glissement est vertigineux.

Et maintenant ?

Je n’ai pas de réponse tranchée à la question de la responsabilité juridique des IA. Seulement davantage de questions. Et un constat : nos représentants doivent agir vite. La technologie avance à toute allure. Il est déjà techniquement possible, en France, de créer des sociétés dirigées de facto par des IA. Et les fautes à venir soulèveront immanquablement la question de la responsabilité.

Peut-on envisager demain des entités purement numériques, sans humains, juridiquement responsables de leurs actes ? Ce débat n’est plus théorique. Il est urgent.

Je suis curieux de connaître vos retours — en particulier ceux des professionnels du droit — sur l’état de la législation en France et à l’étranger. Y a-t-il des pays plus en avance ? Des pistes d’évolution crédibles selon vous ?

Références et lectures complémentaires

Droit des robots et IA : faut-il leur accorder une personnalité juridique ?

Intelligence artificielle et droit : entre tentation d’une personne juridique du troisième type et avènement d’un transjuridisme, Actu-Juridique

La responsabilité du fait des choses à l’ère de l’IA : enjeux juridiques et perspectives

Village de la JusticeSAS, dirigeant personne morale et responsabilité pour insuffisance d’actif : les liaisons dangereuses

Dalloz Actualité